Mit der Entdeckung des neuen Grippestamms H2009N1 im Jahr 1 wurde in den USA das übliche Überwachungs- und Beobachtungsverfahren aktiviert, das die Meldung aller Fälle durch die regionalen Gesundheitskontroll- und Präventionszentren vorsah.

Ein weit verbreitetes und erprobtes Verfahren, das jedoch eine Grenze hatte: Es zeichnete ein Bild der Entwicklung des Virus immer zwei Wochen zu spät im Vergleich zur Notfallsituation.

Im gleichen Zeitraum erschien das Magazin Natur veröffentlichte einen Artikel, in dem einige Google-Ingenieure zu allgemeinem Erstaunen und Unglauben behaupteten, sie könnten die geografische Verbreitung von H1N1 ausschließlich anhand der im Web verwendeten Schlüsselwörter ermitteln und sogar vorhersagen.

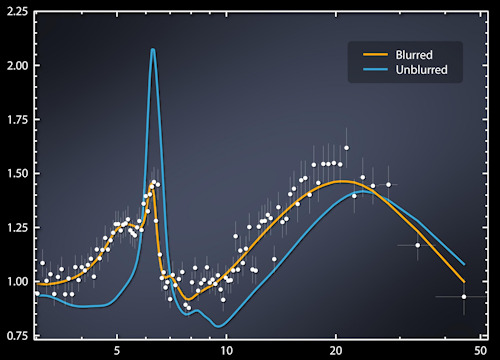

Konkret hatten die Mountain View-Gurus ausgehend von den 50 Millionen Wörtern, die im Internet von US-Nutzern am häufigsten verwendet wurden, die am häufigsten verwendeten Wörter in den von den regionalen Gesundheitszentren gemeldeten Bereichen identifiziert und 450 Millionen verschiedene mathematische Modelle auf sie angewendet, was ihnen gelungen war um einen Zusammenhang zwischen 45 Schlüsselwörtern und der Verbreitung von Viren hervorzuheben.

Die Fakten bestätigten die Nachricht und es wurde erstmals nachgewiesen, dass es möglich war, die Ausbreitung eines Virus mit rein mathematischen Methoden vorherzusagen, im Wesentlichen unter Rückgriff auf (riesige) Datenmengen, die von Maschinen mit ausreichenden Rechenfähigkeiten verarbeitet wurden.

Diese Geschichte ist ein weiterer Beweis dafür, wie sehr die digitale Revolution zugrunde liegt Informationstechnologie (IT) hat unsere Zeit revolutioniert. Damit begann die sogenannte „vierte industrielle Revolution“, ein epochaler Wandel, der sich mit beispielloser Breite und Geschwindigkeit entwickelt und eine noch nie dagewesene Vielfalt an Bereichen erfasst.

Künstliche Intelligenz (KI), Robotik, Biotechnologie, Nanotechnologie, Internet der Dinge (IoT), autonomes Fahren und Quantencomputing sind nur einige der Sektoren, die eine Phase kontinuierlichen Fortschritts durchlaufen, die aufgrund der Vielfalt und Tiefe der Ergebnisse außergewöhnlich ist für seine Entwicklungsgeschwindigkeit.

Beim Akronym IT konzentrieren wir uns oft auf das T für Technologie, also Computer: immer leistungsfähigere Maschinen, die laut einem Gesetz in der Lage sind, ihre Rechenkapazität alle 18 Monate zu verdoppeln – so Moore1 - die zwar keinen wissenschaftlichen Wert hat, aber dennoch durch mehr als 50 Jahre Beobachtung der Realität gestützt wird.

Abgesehen davon und ohne die Bedeutung immer leistungsfähigerer Maschinen zu schmälern, liegt der wahre Reichtum heute in den Daten, oder besser gesagt in den BIG DATA, die aus den Milliarden von Informationen gewonnen werden, die jeden einzelnen Augenblick durch unsere Klicks, Tweets und Kaufpräferenzen erzeugt werden .

Im ersten Quartal 2018 hatte Facebook 2.19 Milliarden aktive Nutzer2, der wiederum mit 200 Milliarden anderen Personen im Netzwerk interagierte: eine Zahl von über 20 % der Weltbevölkerung. Im selben Jahr hatte YouTube XNUMX Milliarden Nutzer, gefolgt von WhatsApp mit XNUMX Milliarden.

Wichtige Zahlen, die eine unerschöpfliche Datenquelle ergeben.

Andererseits ist das Internet eine Umgebung, in der Millionen von Menschen jeden Tag einen wichtigen Teil ihres Lebens verbringen (in Italien im Jahr 6 durchschnittlich 2018 Stunden pro Tag) und Meinungen, Gefühle, Freuden, Sorgen, Kaufpräferenzen usw. austauschen bald.

Eine Reihe individueller Verhaltensweisen, die „datiert“ werden können aufgezeichnet, analysiert und neu geordnet nach wissenschaftlichen Kriterien, die kontinuierlich Daten produzieren.

Vor allem zwei Beispiele geben einen Eindruck davon, wie die von uns gesuchten Ergebnisse in den Informationen verborgen sind.

Im Jahr 2006 veröffentlichte das AoL-Portal (Americaonline) für Wissenschaftler und Forscher eine Datenbank mit 20 Millionen „Anfragen“, die innerhalb von drei Monaten von 675 Nutzern ausgefüllt wurden, und machte dies aus Schutzgründen zuvor anonym , Benutzer in verschiedenen Funktionen beteiligt. Dennoch wurde innerhalb weniger Tage eine 4417749-jährige Witwe aus Georgia, Thelma Arnold, – zu Recht – mit der Benutzernummer XNUMX in Verbindung gebracht, was einen Streit auslöste, der zur Entlassung von drei AoL-Mitarbeitern führte.

Und selbst als Netflix die Vorlieben von etwa einer halben Million anonymer Nutzer veröffentlichte, dauerte es nicht lange, bis eine Dame aus dem Mittleren Westen anhand ihres Namens und ihrer Adresse erkannt wurde. Forscher der University of Texas zeigten später, dass es tatsächlich möglich ist, einen Kanalnutzer zu erkennen, indem er nur 6 von 500 Filmen auswählt.

Aber es ist nicht nur das Internet: Denken wir an die Kameras, überall auf den Straßen und Plätzen unserer Städte, und an die Art und Weise und den Zweck, mit denen die Spuren, die wir hinterlassen, von einer speziellen Gesichtserkennungssoftware (vor einigen Jahren ein...) genutzt werden können Eine englische Zeitung entdeckte, dass sich im Umkreis von 200 Metern um das Haus, in dem George Orwell, der Autor des dystopischen Buches „1984“, gelebt hatte, nicht weniger als 30 Kameras befanden.

Laut Viktor Schonberger und Keneth Cukier in ihrem grundlegenden Werk3 (als Hauptquelle für diesen Artikel verwendet) wurden im Jahr 2012 so viele Daten produziert, dass sie, wenn sie auf eine CD-ROM geladen würden, fünf parallele Stapel bilden würden, die den Mond erreichen könnten, wohingegen dies bei einer gedruckten Version auf Papier möglich gewesen wäre dreimal das gesamte Territorium der USA abdecken.

Beachten Sie, dass wir von etwa 6 Jahren sprechen und dass sich die jedes Jahr produzierten Daten inzwischen noch einmal verdoppelt haben (im Durchschnitt eine Verdoppelung alle drei Jahre).

Daten stellen das schwarze Gold unserer Zeit dar: ein unschätzbarer Wert, da sie quantitativ und vielfältig genutzt werden können und sich oft von denen unterscheiden, für die sie ursprünglich erhoben wurden. Tatsächlich stellen wir im Netz immer häufiger Informationen zu Zwecken zur Verfügung, die zum Zeitpunkt ihrer Erhebung noch nicht bekannt waren.

Daten stellen das schwarze Gold unserer Zeit dar: ein unschätzbarer Wert, da sie quantitativ und vielfältig genutzt werden können und sich oft von denen unterscheiden, für die sie ursprünglich erhoben wurden. Tatsächlich stellen wir im Netz immer häufiger Informationen zu Zwecken zur Verfügung, die zum Zeitpunkt ihrer Erhebung noch nicht bekannt waren.

Sie befeuern die neuen Grenzen der KI und bilden ihren ersten Treibstoff: Dank ihnen entwickeln sich Computer weiter und beginnen, die äußere Realität „wahrzunehmen“.

Durch die Roboter beginnen sie, autonome Aktionen auszuführen4, auf der Grundlage von extern gesammelten und analysierten Situationsdaten (und nicht auf der Grundlage der erhaltenen Programmierung) entschieden.

Doch wie werden BIG DATA genutzt? Durch die Anwendung mathematischer Methoden, „Algorithmen“, die auf der Grundlage dessen ausgearbeitet werden, was man zu einem bestimmten Zeitpunkt über ein bestimmtes Phänomen entdecken möchte.

Dabei handelt es sich um Algorithmen, die es ermöglichen, mithilfe großer Datenmengen etwaige „Korrelationen“ zu erkennen, d. h. die Wahrscheinlichkeit, dass sich eine gegebene Beziehung zwischen den untersuchten Elementen wiederholen kann.

Die Tatsache, dass diese Zusammenhänge durch reinen Zufall entstehen, beeinträchtigt nicht die Gültigkeit der Studie selbst, da die Ungenauigkeit und Ungenauigkeit statistisch gesehen „Fix" im Verhältnis zur Menge der verfügbaren Daten.

Bei allem Respekt vor dem Kausalitätsprinzip, das im Zeitalter von SMALL DATA in Ordnung war, als das Verständnis auf einer sorgfältigen Analyse der (begrenzten) verfügbaren Elemente basierte, die von „Experten“ in dem jeweiligen untersuchten Sektor durchgeführt wurde.

Im Zeitalter von BIG DATA wird das Verständnis von Phänomenen stattdessen mit Hilfe von „Datenwissenschaftlern“ – einer Mischung aus Programmierer, Mathematiker und Statistiker – und nicht mit traditionellen Experten erreicht.

Tatsächlich liegt die Wahrheit in Big Data: Es überrascht nicht, dass Algorithmen, die mit begrenzten Datenmengen unbefriedigende (wahrscheinliche) Ergebnisse liefern, Wunder wirken, wenn sie auf größere Zahlen angewendet werden.

„Google Translator“ ist ein klares Beispiel dafür, wie das probabilistische Kriterium in Kombination mit der Informationsmenge zur Lösung eines komplexen Problems wie der Übersetzung angewendet werden kann.

Tatsächlich übersetzt das Programm nicht, indem es Grammatikregeln anwendet oder auf auswendig gelernte Wörterbücher zurückgreift, sondern indem es sich auf die Wahrscheinlichkeiten stützt, dass der Inhalt eines bestimmten Dokuments entsprechend den grammatikalischen Strukturen und der Bedeutung von Wörtern, Verben und Adjektiven übersetzt werden kann in den Milliarden Dokumenten in allen Sprachen präsent, die es im Gedächtnis hat.

Damit gewann das Programm den Wettbewerb mit Microsoft und wurde schnell zum meistgenutzten Übersetzer der Welt.

In einem solchen Kontext stellt die Rechenkapazität, wie bereits erwähnt, nur einen Teil des Prozesses dar, nicht einmal den wichtigsten, sowie die Algorithmen, die von Zeit zu Zeit verwendet werden. Der entscheidende Faktor bleibt die Menge der verfügbaren Daten: Je mehr wir haben, desto wahrscheinlicher ist es, dass wir finden, wonach wir suchen.

BIG DATA „beflügeln“ die vierte industrielle Revolution und ermöglichen ein besseres Verständnis der Welt. Zu lernen, wie man mit ihnen umgeht und sie optimal nutzt, ist die Herausforderung, die auf uns wartet.

3BIG DATA von Viktor Schonberger und Keneth Cukier – Garzanti 2013

4Ein System wird als „automatisiert“ bezeichnet, wenn es hauptsächlich deterministisch agiert und immer auf die gleiche Weise reagiert, wenn es denselben Eingaben ausgesetzt ist. Ein „autonomes“ System hingegen argumentiert auf probabilistischer Basis: Nachdem es eine Reihe von Eingaben erhalten hat, verarbeitet es die besten Antworten. Im Gegensatz zu automatisierten Systemen kann ein autonomes System bei gleichen Eingaben unterschiedliche Antworten liefern.

Foto: Emilio Labrador / NASA